What's in AI - #30

Tu dosis semanal de Inteligencia Artificial 🤖 Por Abilio Romero y Juan Águila.

El 6 de octubre de 2010 se lanza Instagram, creado por Kevin Systrom y Mike Krieger.

Esta fue su primera foto:

Probablemente parte de su éxito se deba a la exitosa incorporación de algoritmos para mejorar el contenido mostrado y, por lo tanto, aumentar el engagement de los usuarios.

Algunos ejemplos de este uso de la IA son:

Personalización del Feed

Explorar y Descubrimiento de Contenido: La pestaña "Explorar" utiliza IA para recomendar publicaciones y cuentas que se ajusten a los intereses del usuario

Filtros y Efectos de Realidad Aumentada

Moderación de Contenido: La plataforma emplea sistemas de IA para detectar y eliminar contenido que viola las políticas de la comunidad, incluyendo lenguaje ofensivo, spam y comportamientos inapropiados.

Publicidad dirigida

Esta semana en WIAI…

🔄💼 Sigue la sangría en OpenAI: Mira Murati también se va tras ser clave en ChatGPT

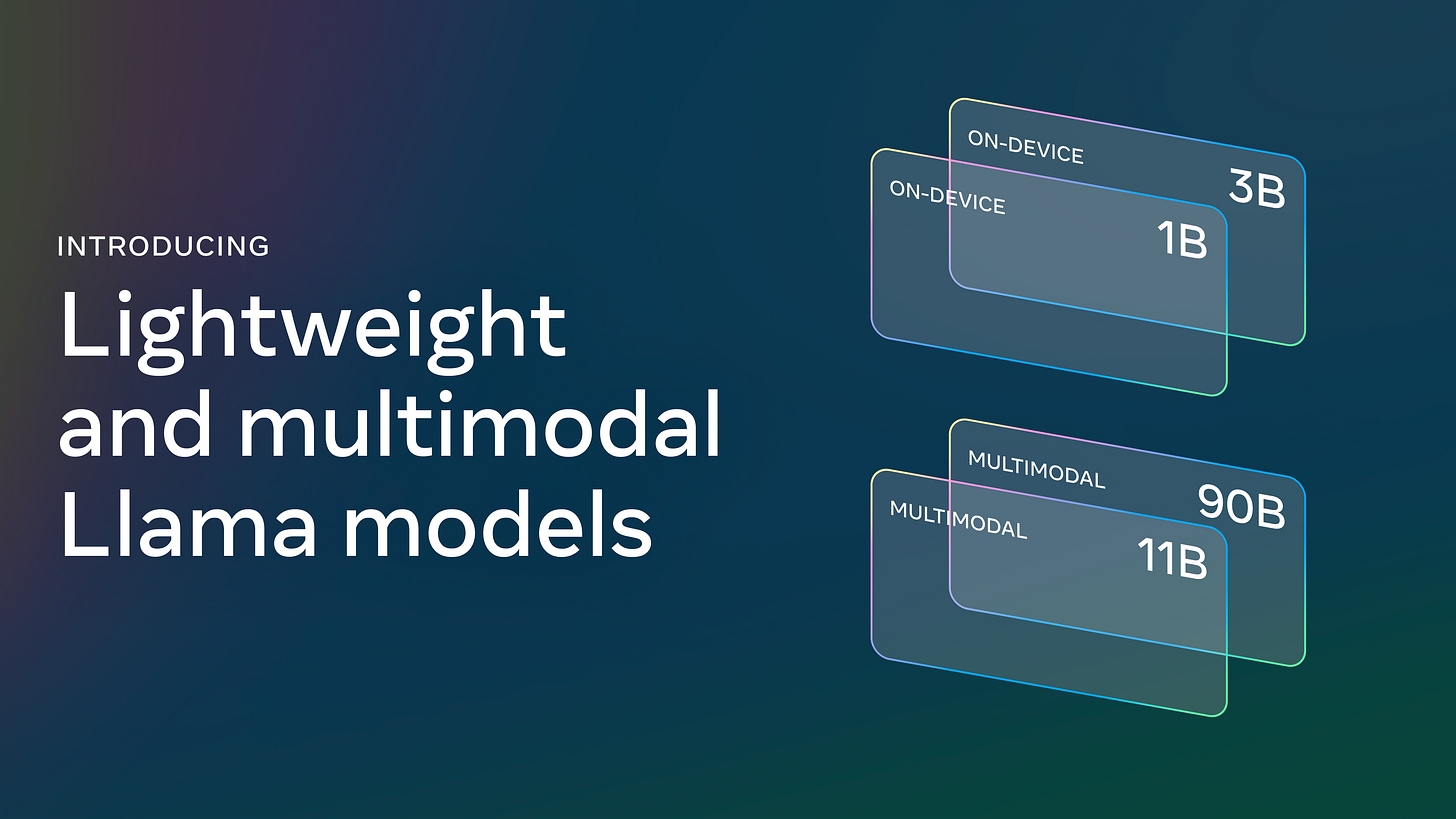

🧠🔓 Meta publica nuevos modelos multimodales: Llama 3.2

📚 Junto con otras noticias interesantes sobre IA

No te pierdas nada

🔄💼 Sigue la sangría en OpenAI: Mira Murati también se va tras ser clave en ChatGPT

Tras seis años y medio en OpenAI, Murati, responsable del éxito de ChatGPT, deja la compañía para explorar nuevas oportunidades.

Solo quedan dos de los once cofundadores de OpenAI en activo, con Greg Brockman en excedencia.

Murati estuvo entre las figuras que podrían haber reemplazado a Altman cuando fue despedido, pero con su partida, la compañía pierde otro miembro central en su cúpula directiva.

🔊🌍 El modo de voz al más puro estilo ‘Her’ empieza a llegar a ChatGPT. Los usuarios de la UE tendremos que seguir esperando

El modo de voz introduce cinco voces nuevas, basadas en modelos avanzados de inteligencia artificial. Este cambio busca ofrecer interacciones más humanas y naturales.

Aunque el despliegue global de esta funcionalidad ha comenzado, los usuarios de la UE enfrentarán una espera mayor debido a cuestiones regulatorias que deben resolverse antes de que esta característica esté disponible en dicha región.

🧠🔓 Meta publica nuevos modelos multimodales: Llama 3.2

Con versiones de 1B y 3B parámetros, Llama 3.2 está diseñado para ejecutarse directamente en dispositivos móviles con procesadores como Qualcomm y MediaTek, lo que facilita la implementación de IA avanzada en smartphones y tablets sin necesidad de depender de la nube.

Las versiones más grandes de Llama 3.2 (11B y 90B) están diseñadas específicamente para tareas de visión por computadora.

Meta ha lanzado también Llama Stack, una plataforma de código abierto que permite a empresas personalizar y desplegar Llama 3.2 de acuerdo a sus necesidades específicas.

🎨🔮 Aparece un misterioso modelo Blueverry_0, mejora todos los modelos existentes de generación de imágenes

Este nuevo modelo se coloca el primero en los modelos de texto to image

Puedes probarlo aquí

Se sospecha que podría ser una nueva versión de Flux, aunque aún ninguna empresa lo ha reconocido como suyo

Si tienes ganas de mas…

Google etiquetará así las fotos creadas con inteligencia artificial

Los padres no saben lo que hacen sus hijos. Ahora también aplica a la inteligencia artificial

🎁 Bonus track

Cinco papers para entender mejor qué podría haber detrás de la capacidad de razonamiento del modelo o1 de OpenAI:

Quiet-STaR: Language Models Can Teach Themselves to Think Before Speaking (https://lnkd.in/eCPaa-wc) from Stanford

Agent Q: Advanced Reasoning and Learning for Autonomous AI Agents (https://lnkd.in/eebwEkPi) from MultiOn/Stanford

Let's Verify Step by Step (https://lnkd.in/egf6EpMd) from OpenAI

V-STaR: Training Verifiers for Self-Taught Reasoners (https://lnkd.in/ebRcEKBn) from Microsoft, Mila**

Learn Beyond The Answer: Training Language Models with Reflection for Mathematical Reasoning (https://lnkd.in/eeeaqm6x) from Notre Dam, Tencent

Gracias a Philipp Schmid por compartirlo.

Y si te ha gustado la publicación, ¡no olvides compartirla!

Y si aún no estas suscrito, ¿a qué esperas? 😉

Déjanos tu opinión: