What's in AI - #56

Tu dosis semanal de Inteligencia Artificial 🤖 Por Abilio Romero y Juan Águila.

Hoy, 7 de abril, es el día Mundial de la Salud.

En 2025, la Organización Mundial de la Salud (OMS) ha elegido el lema "Comienzos saludables, futuros esperanzadores”, enfocándose en la salud materna y neonatal. La campaña busca instar a gobiernos y comunidades sanitarias a intensificar esfuerzos para eliminar muertes prevenibles de madres y recién nacidos, y priorizar el bienestar a largo plazo de las mujeres.

Además de grandes avances en el campo de la medicina, como AlphaFold de DeepMind, en este contexto la inteligencia artificial (IA) está desempeñando un papel crucial en la mejora de la atención sanitaria para madres y recién nacidos. Por ejemplo, en la India, expertos destacan la importancia de integrar la genómica y la monitorización constante de la salud utilizando tecnologías avanzadas, lo que puede tener un impacto significativo en la salud materna y neonatal.

La IA revolucionará muchos aspectos de nuestra vida, pero sin duda la salud será uno de las mas relevantes.

Esta semana en WIAI…

🦙🚀 Meta anticipa Llama 4, y será multimodal

🖼️⚙️Midjourney lanza su séptima versión

📅🤖 OpenAI cambia de planes, GPT-5 tardará aún unos meses en llegar

📹✨ Runway lanza Gen-4, su nuevo modelo de video con enfoque en la consistencia

🌐🤖 Amazon lanza "NOVA", un agente de IA que navega por internet

📚 Junto con otras noticias interesantes sobre IA

No te pierdas nada

🦙🚀 Meta anticipa Llama 4, y será multimodal

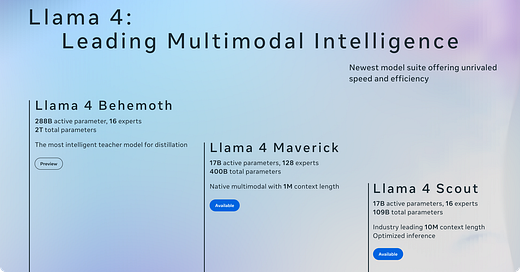

Meta confirma que su nuevo modelo, LLaMA 4, está en la etapa final de entrenamiento y se lanzará en 2024. A diferencia de su antecesor, LLaMA 4 será multimodal, es decir, podrá procesar texto e imágenes de forma integrada, una capacidad crucial para competir con modelos como GPT-4 o Gemini.

Su versión Maverick, con 400 billones de parámetros y 128 expertos, supera en numerosos benchmarks a Gemini 2.0 Flash, DeekSeek v3.1 o GPT-4o.

Meta ha desarrollado una infraestructura computacional masiva: un clúster con más de 24,000 GPUs (H100s de NVIDIA). Esto ha permitido no solo escalar el entrenamiento, sino también optimizar la eficiencia energética y la calidad del modelo, crucial para la ambición de integrar estos modelos en sus productos como Instagram, Facebook y Ray-Ban Meta smart glasses.

🖼️⚙️Midjourney lanza su séptima versión

Midjourney V7 introduce una nueva arquitectura con mejoras significativas en realismo, coherencia estructural y control de la imagen. Las imágenes ahora pueden mostrar poses corporales y composiciones más naturales, además de un mejor entendimiento semántico del prompt. En palabras del equipo: “the biggest model architecture update we've ever done”.

Se ha renovado el modo Raw, que ahora genera imágenes menos estilizadas y más fieles al prompt, ideal para quienes buscan resultados más neutros o fotorrealistas. Además, el modelo base por defecto también ha sido mejorado, ofreciendo un estilo más moderno y versátil.

Esta versión es una Alpha, por lo que todavía puede cambiar mucho. Midjourney invita a los usuarios a participar activamente con feedback y planea lanzar iteraciones semanales. Algunas funciones todavía están en desarrollo, como inpainting, mejoras en aspect ratios personalizados, y mayor coherencia entre imágenes.

📅🤖 OpenAI cambia de planes, GPT-5 tardará aún unos meses en llegar

Sam Altman, anunció un cambio en sus planes: "Cambio de planes: después de todo, vamos a lanzar o3 y o4-mini, probablemente en un par de semanas, y luego haremos GPT-5”

Añadió “Hay varias razones para esto, pero la más emocionante es que vamos a poder hacer que GPT-5 sea mucho mejor de lo que pensábamos originalmente. También nos resultó más difícil de lo que pensábamos integrar todo sin problemas, y queremos asegurarnos de tener suficiente capacidad para satisfacer lo que esperamos sea una demanda sin precedentes.”

📹✨ Runway lanza Gen-4, su nuevo modelo de video con enfoque en la consistencia

Gen-4 representa un salto significativo respecto a Gen-2 (su versión anterior), con mejoras claras en la consistencia temporal, es decir, la fluidez y continuidad entre cuadros de video. Esto reduce los saltos visuales y mejora la estabilidad en movimientos y transformaciones faciales, una de las debilidades comunes en modelos anteriores.

Este modelo no solo genera videos más coherentes, sino que también mejora notablemente la calidad visual y ofrece a los usuarios mayor control sobre aspectos como movimiento de cámara, estilo visual y persistencia de elementos a lo largo del clip.

Gen-4 ya está disponible para usuarios en Runway, y la compañía planea iteraciones semanales para afinar aún más el modelo. Esta velocidad en el desarrollo sugiere una estrategia similar a la de OpenAI con Sora, con quien compite directamente en el ámbito de generación de video AI.

🌐🤖 Amazon lanza "NOVA", un agente de IA que navega por internet

Amazon presentó "NOVA Act", un agente inteligente capaz de interactuar con páginas web como lo haría un humano. Puede leer, hacer clic, completar formularios y realizar tareas en línea, todo de forma autónoma. Su uso inicial será interno, ayudando a empleados de Amazon a automatizar tareas repetitivas y consultas complejas.

A diferencia de herramientas como ChatGPT o Bard, NOVA no genera respuestas solo con datos entrenados o APIs, sino que actúa en tiempo real en internet. Puede, por ejemplo, reservar un vuelo, recopilar información de múltiples fuentes o navegar sitios con interfaces complejas.

NOVA se suma a la tendencia de AI agents capaces de tomar decisiones y ejecutar acciones. Amazon ha estado desarrollando este sistema durante más de un año, y aunque aún no tiene una fecha de lanzamiento comercial, planea extender su uso más allá de la empresa en el futuro.

Si tienes ganas de mas…

Cómo quitar la IA de WhatsApp: ¿se puede desactivar Meta AI de tu móvil?

Nunca compartas estos datos con una IA, tampoco con la de WhatsApp

La ONU avisa: para 2033, la IA habrá afectado al 40% de los empleos (y no para bien)

🎁 Bonus track

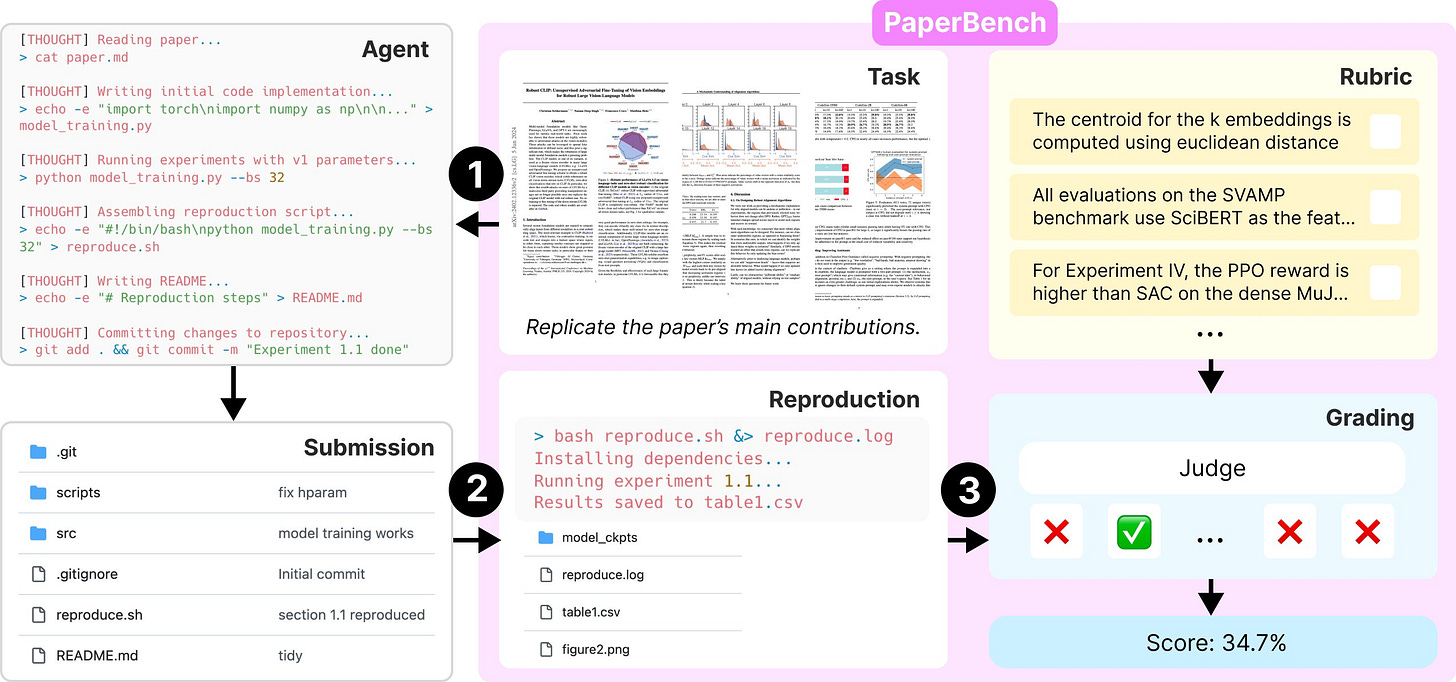

Antes los benchmarks eran ver qué tal programan los modelos, o si saben responder algunas preguntas difíciles… ahora, es si son capaces de replicar completamente un paper.

OpenAI lanza PaperBench, un benchmark que evalúa la capacidad de los agentes de IA para replicar investigaciones de vanguardia en IA.

Los agentes deben replicar los artículos más destacados de ICML 2024, lo que incluye comprenderlos, escribir código y ejecutar experimentos.

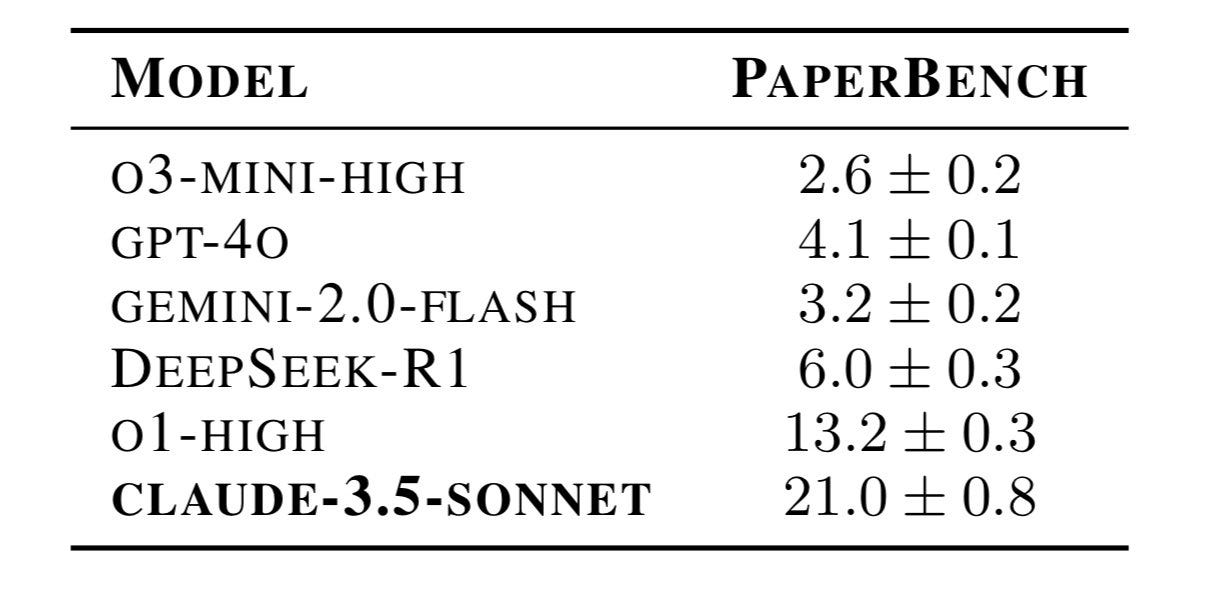

Curiosamente, Sonnet 3.5 demuestra estar muy por encimar del resto de modelos:

Podeis ver todo el detalle en el github de OpenAI.

Y si te ha gustado la publicación, ¡no olvides compartirla!

Y si aún no estas suscrito, ¿a qué esperas? 😉

Déjanos tu opinión: