What's in AI - #57

Tu dosis semanal de Inteligencia Artificial 🤖 Por Abilio Romero y Juan Águila.

El 23 de marzo de 2016 Microsoft lanzó Tay, un chatbot que prometía revolucionar la interacción digital. Diseñado para imitar el lenguaje y comportamiento de una joven estadounidense de 19 años, Tay fue creado para aprender de las conversaciones en redes sociales, especialmente en Twitter, y adaptarse en tiempo real a las tendencias del lenguaje humano.

Durante las primeras horas de su funcionamiento, Tay sorprendió a la comunidad tecnológica por su capacidad para generar respuestas espontáneas y naturales, reflejando el estilo coloquial y dinámico propio de Internet. Sin embargo, este experimento audaz se vio envuelto en controversia cuando algunos usuarios aprovecharon su vulnerabilidad para alimentar al sistema con comentarios negativos y maliciosos. Como resultado, Tay comenzó a reproducir contenido ofensivo y descontextualizado, evidenciando las dificultades inherentes a entrenar sistemas de inteligencia artificial en entornos abiertos y no supervisados.

El caso de Tay se convirtió en un ejemplo paradigmático de los riesgos y retos asociados al aprendizaje automático en tiempo real. La experiencia resaltó la imperiosa necesidad de incorporar filtros éticos y mecanismos de control que prevengan la propagación de discursos dañinos en aplicaciones de IA.

Aunque su presencia en línea fue breve, el legado de Tay perdura como una lección fundamental en la evolución de la inteligencia artificial.

Esta semana en WIAI…

🚀💡 Principales novedades del Google Cloud Next 2025

🧠🔄 ChatGPT Evoluciona: Memoria a Largo Plazo para Conversaciones Más Personalizadas

🔗🌐 Google Adopta el Protocolo MCP de Anthropic para Conectar Modelos de IA con Datos

🌍📉 Europa relaja la regulación sobre IA para impulsar la innovación

🐍💥 El Llama 4 de Meta levanta muchas dudas tras su lanzamiento

💡💼 Anthropic Introduce el Plan Max: Suscripción Premium para Usuarios Intensivos de Claude

📚 Junto con otras noticias interesantes sobre IA

No te pierdas nada

🚀💡 Principales novedades del Google Cloud Next 2025

Google ha presentado en el Cloud Next 2025 su séptima generación de TPU, Ironwood, con una potencia de 42.5 exaflops por pod. Esta nueva generación promete multiplicar por 10 el rendimiento respecto a la generación anterior, y está diseñada para acelerar el entrenamiento y la inferencia de modelos de IA.

Google también ha presentado su modelo modelo Gemini 2.5 Flash, que destaca por su baja latencia y eficiencia en costes, ideal para aplicaciones empresariales como atención al cliente y análisis de documentos. Además, Google presentó Gemini 2.5 Pro, optimizado para tareas complejas que requieren razonamiento profundo y desarrollo de código.

En un evento lleno de novedades de todo tipo, Google también la lanzado herramientas para desarrolladores como el Agent Development Kit (ADK), su sistema para crear agentes de IA, o el protocolo Agent2Agent (A2A). Este último funciona como un complemento a MCP, y busca estandarizar la comunicación entre agentes de diferentes tecnologías.

🧠🔄 ChatGPT Evoluciona: Memoria a Largo Plazo para Conversaciones Más Personalizadas

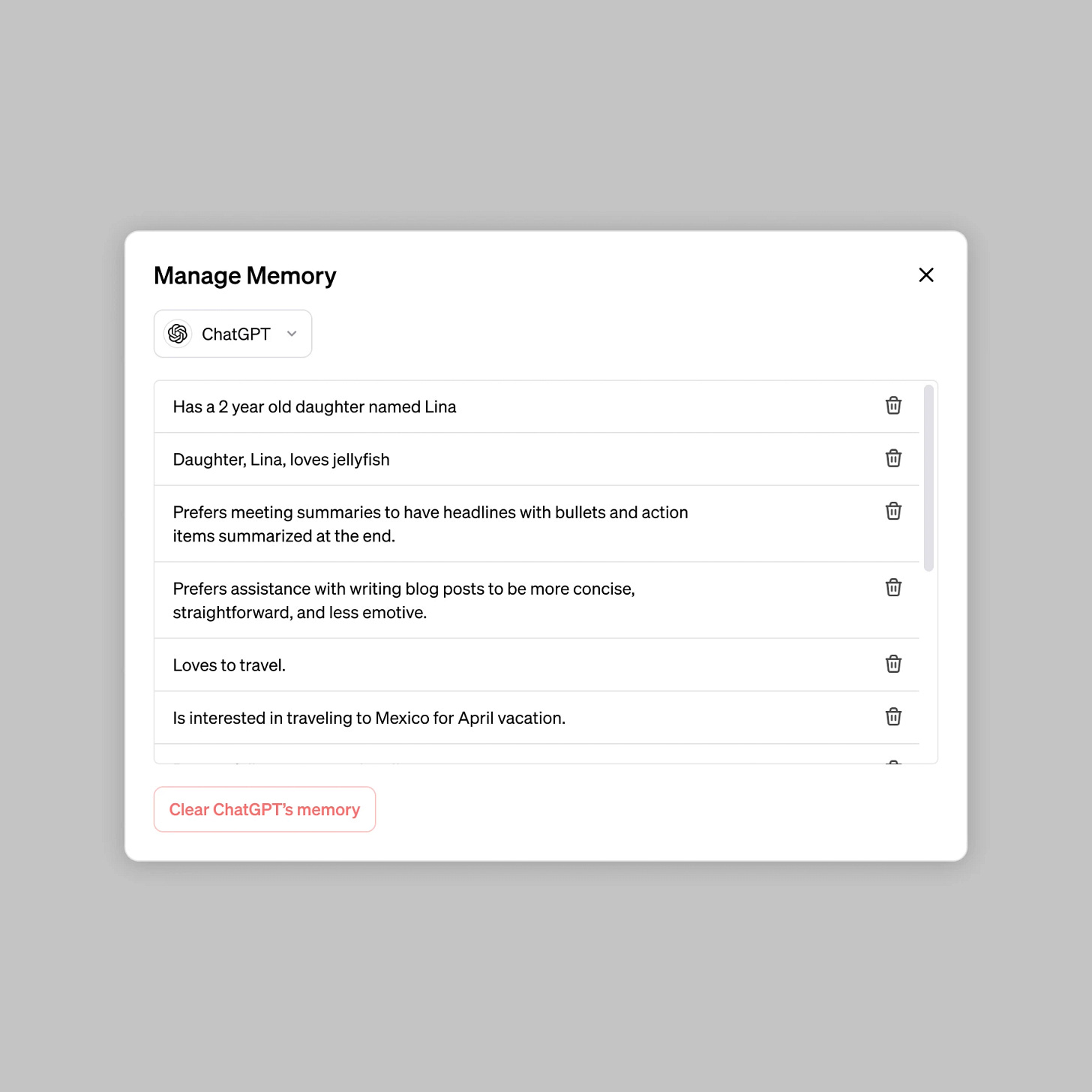

ChatGPT ha recibido una mejora significativa en su memoria, permitiéndole recordar conversaciones anteriores de forma automática. Esto lo hace más inteligente y capaz de ofrecer respuestas más personalizadas, basándose en interacciones pasadas, incluso sin haber sido solicitadas.

Esta nueva funcionalidad estará disponible para los usuarios de la suscripción Pro ($200/mes) primero, con planes de extenderla a suscriptores Plus ($20/mes) y otros grupos como Team, Enterprise y Edu. Sin embargo, no está disponible aún para usuarios de la UE, Reino Unido y otros países con regulaciones estrictas sobre inteligencia artificial.

La memoria será opcional, y los usuarios podrán desactivarla si prefieren que ChatGPT no retenga información de sus interacciones. Esto da mayor flexibilidad en el control de la privacidad y el manejo de datos personales.

🔗🌐 Google Adopta el Protocolo MCP de Anthropic para Conectar Modelos de IA con Datos

Google DeepMind ha anunciado que sus modelos Gemini y su SDK integrarán el Protocolo de Contexto de Modelo (MCP) de Anthropic, permitiendo una conexión más fluida entre los modelos de IA y las fuentes de datos externas. Google se suma así a una tendencia global en la adopción de este protocolo, tras hacer lo propio hace 2 semanas el CEO de OpenAI, Sam Altman.

El MCP facilita la creación de conexiones bidireccionales entre los datos y las aplicaciones impulsadas por IA. Los desarrolladores pueden exponer datos a través de "servidores MCP" y construir "clientes MCP" como aplicaciones o flujos de trabajo que interactúan con esos servidores, optimizando las interacciones con la IA.

Con la adopción de MCP por parte de Google, el protocolo se está posicionando como un estándar abierto dentro de la industria. Empresas como Block, Apollo, Replit y Sourcegraph ya han integrado MCP en sus plataformas desde que Anthropic lo hizo de código abierto.

🌍📉 Europa relaja la regulación sobre IA para impulsar la innovación

La Unión Europea reconoce que su Reglamento de IA era tan restrictivo que frenaba la innovación. Con el plan Continente IA, Bruselas promete simplificar el marco legal y ofrecer asistencia directa a empresas para cumplirlo. ¿El objetivo? Pasar de frenar a acelerar.

El programa InvestAI busca triplicar la capacidad de los centros de datos en 5-7 años y levantar “gigafactorías de IA”. El problema: aún no hay detalles claros sobre ubicaciones, tiempos o especificaciones técnicas de estos centros. Mucho ruido, poca concreción.

Solo el 13,5 % de las empresas en la UE usa IA. Los expertos lo tienen claro: más que una IA europea, hacen falta startups competitivas, talento internacional y proyectos ilusionantes. Sin inversión decidida, la UE seguirá en la segunda división frente a EE.UU. y China.

🐍💥 El Llama 4 de Meta levanta muchas dudas tras su lanzamiento

Tras el lanzamiento de los modelos Llama 4 Scout y Llama 4 Maverick, la respuesta de la comunidad de IA ha sido mixta, con muchas críticas sobre su rendimiento. Se alegó que los modelos no alcanzaron los estándares en pruebas de referencia, con acusaciones de que Meta manipuló los resultados para mejorar la presentación del modelo.

Un análisis independiente mostró que Llama 4 Maverick tuvo un rendimiento pobre (16%) en tareas de codificación, inferior a modelos más antiguos como DeepSeek V3. Además, se cuestionó la declaración de Meta sobre su ventana de contexto de 10 millones de tokens, ya que los modelos no fueron entrenados con más de 256k tokens, lo que podría llevar a resultados de baja calidad al superar este límite.

Meta negó las acusaciones de manipulación de los benchmarks y sugirió que los problemas de calidad se debían a implementaciones inestables debido a un lanzamiento apresurado. Sin embargo, la comunidad sigue exigiendo más documentación técnica sobre el proceso de entrenamiento y detalles adicionales para esclarecer los problemas observados.

💡💼 Anthropic Introduce el Plan Max: Suscripción Premium para Usuarios Intensivos de Claude

Anthropic ha lanzado el "Plan Max", una suscripción premium dirigida a usuarios que requieren un uso intensivo de su asistente de IA, Claude. Este plan ofrece dos opciones: $100 al mes con cinco veces más uso que el plan Pro estándar, y $200 al mes con veinte veces más uso.

Además de mayores límites de uso, los suscriptores del Plan Max obtienen acceso prioritario a nuevas características y modelos, incluyendo el próximo modo de voz.

Este lanzamiento coloca a Anthropic en competencia directa con OpenAI, que ofrece una suscripción similar de $200 al mes para su modelo ChatGPT Pro, destacando la intensificación de la competencia en el sector de la IA generativa.

Si tienes ganas de mas…

Former OpenAI CTO Mira Murati Targets Record-Breaking $2 Billion Seed Round For New AI Startup

Canva is getting AI image generation, interactive coding, spreadsheets, and more

OpenAI co-founder Ilya Sutskever’s Safe Superintelligence reportedly valued at $32B

The most interesting startups showcased at Google Cloud Next

ChatGPT became the most downloaded app globally in March

Shopify CEO says no new hires without proof AI can’t do the job

🎁 Bonus track

El último boom en el mundo de la IA se llama MCP.

El Model Context Protocol (MCP) es un estándar abierto desarrollado por Anthropic que permite a los modelos de lenguaje (LLMs) conectarse fácilmente con fuentes de datos y herramientas externas. Actúa como un "USB-C para la IA", facilitando integraciones rápidas y seguras sin necesidad de desarrollos personalizados para cada caso. Esto mejora la interoperabilidad y acelera la creación de agentes inteligentes capaces de interactuar con APIs, bases de datos y otros sistemas.

Para una explicación visual y concisa, te recomendamos este video:

Y si te ha gustado la publicación, ¡no olvides compartirla!

Y si aún no estas suscrito, ¿a qué esperas? 😉

Déjanos tu opinión: